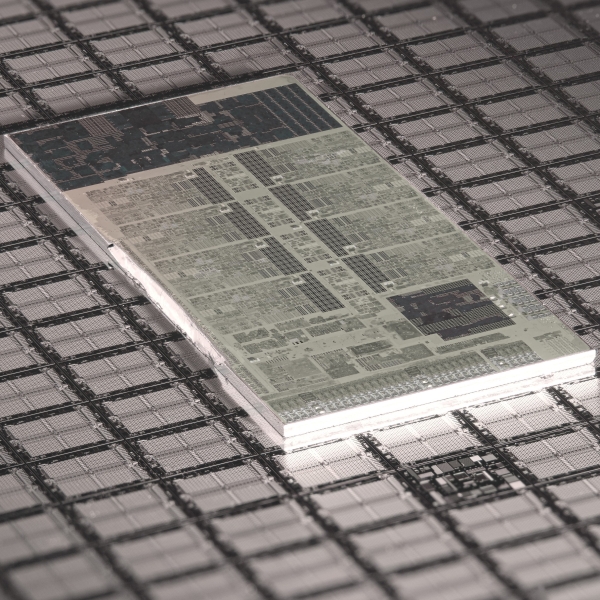

Veille M3 / Quand les corps se dématérialisent pour s’arracher à l’emprise du temps : des zombies au grand jour dans la Vallée du Silicium

Article

Le progrès technologique nous éblouit. Se pourrait-il qu’il nous aveugle en plein jour ?

Vous êtes ici :

Article

Tag(s) :

Un algorithme est une suite logique finie, organisée et ordonnée d’instructions permettant à un ordinateur d’effectuer une tâche ou de résoudre un problème.

Ce protocole de calcul traite des données en entrée pour produire un résultat, selon des règles prédéfinies.

Omniprésent dans les moteurs de recherche, les réseaux sociaux ou l’IA, il optimise, classe et/ou recommande des contenus en fonction de modèles statistiques.

Les algorithmes structurent notre accès à l’information et influencent les termes des débats publics : leurs « recommandations » agissent comme des filtres et peuvent contribuer à ce que l’on appelle des bulles informationnelles. En leur sein, sur les réseaux sociaux, l’expérience de chaque utilisateur est unique et personnalisée par le biais d’un fil d’actualités ou d’un flux de recommandations.

Ces suggestions ont pour visée prioritaire de capter notre attention pour la convertir en recettes publicitaires. Cela induit une orientation des informations auxquelles nous accédons : les contenus proposés s’avèrent conformes à nos centres d’intérêt et à nos opinions, mais concrètement, nous enferment dans un environnement qui ne peut que confirmer nos opinions initiales, coupant cours à la contradiction et à l’échange d’arguments.

L’opacité et les biais des algorithmes, liés à la représentation que leurs concepteurs ont du monde, peuvent renforcer les stéréotypes, polariser l’opinion ou favoriser la désinformation. Leur régulation pose des questions de transparence, de responsabilité et de souveraineté numérique, essentielles pour préserver la démocratie à l’ère du numérique.

L’anonymat vise à empêcher l’identification et surtout la « traçabilité » : relier des actes entre eux ou à une personne. Il se distingue du pseudonymat, où un identifiant stable permet encore la corrélation.

Un anonymat robuste vise l’intraçabilité — c’est-à-dire l’impossibilité de relier différentes actions ou communications à la même identité (unlinkability) — ainsi que la résistance à la réidentification (éviter qu’une personne soit reconnue à partir de ses traces numériques).

Pour atteindre ces objectifs, plusieurs outils et pratiques sont utilisés : les mixnets (voir plus bas), Tor (un réseau qui masque l’adresse IP de l’utilisateur pour anonymiser le trafic Internet), et des pratiques d’opsec (sécurité opérationnelle consistant à limiter les risques de divulgation d’informations personnelles lors des interactions en ligne).

Les mixnets contribuent à l’intraçabilité en brouillant l’origine des messages, Tor protège contre la réidentification en cachant les adresses IP et les parcours de navigation, tandis que l’opsec réduit les possibilités de fuite d’informations permettant d’identifier quelqu’un.

L’anonymat protège la liberté d’expression, le droit d’alerte, la consultation de sujets sensibles, ou le simple fait de chercher sans être fiché·e. Il protège aussi contre harcèlement, discrimination ou répression quand l’environnement politique se durcit. Il n’implique pas l’impunité, mais rend possible la prise de parole sans peur, tout comme le droit de lire, d’enquêter ou de s’organiser. Sans cela, l’espace public se rétrécit.

L’Internet backbone (dorsale d’Internet) désigne les liaisons et équipements à très haute capacité qui transportent le trafic sur de longues distances et assurent l’interconnexion entre grands réseaux (opérateurs, clouds, administrations, etc.). Il repose sur des accords d’interconnexion (soit un échange direct de trafic entre réseaux, soit l’achat d’un accès au reste d’Internet auprès d’un opérateur) et des points d’échange : c’est ce qui permet à Internet de fonctionner comme un ensemble interconnecté plutôt que des réseaux isolés.

Le backbone conditionne la qualité (latence, congestion), la résilience (redondance, pannes) et des dépendances souvent invisibles (où passent les flux, les routes alternatives, etc.). À l’échelle d’une collectivité, c’est un sujet de continuité de service et de vulnérabilités systémiques (économie, secours, administration, santé, etc.).

Les câbles sous‑marins sont des fibres optiques posées au fond des mers reliant des stations d’atterrissement (interface où les câbles immergés atteignent la surface) : ils portent l’essentiel du trafic international et constituent une composante critique du backbone mondial. Leur géographie (routes, points d’atterrissement, redondance) structure concrètement les chemins de données entre continents.

Une rupture, une saturation ou un incident peut provoquer des ralentissements, des coupures régionales ou des détours plus coûteux. C’est un enjeu de sécurité et de gouvernance (protection, réparation, coordination internationale) qui pèse indirectement sur la continuité des services numériques.

Les liaisons satellitaires ne remplacent pas la fibre, mais peuvent compléter la dorsale : couverture de zones isolées, continuité en cas de rupture terrestre, et surtout backhaul (liaison de collecte : relier une antenne mobile, un site isolé ou un réseau local au cœur de réseau). On parle d’intégration via les NTN (Non‑Terrestrial Networks, « réseaux non terrestres »).

Les constellations LEO (Low Earth orbit, orbite basse) ont souvent une latence plus faible que les satellites GEO (Geostationary orbit, orbite géostationnaire), et le trafic repasse par des stations au sol (gateways) avant de revenir sur les réseaux terrestres.

Pour les territoires peu desservis, le satellite peut fournir un accès (ou un secours) ; pour une collectivité, c’est une brique possible dans un plan de continuité. Mais cela implique des arbitrages : coûts, dépendance à un opérateur, localisation des gateways, conditions d’usage, et questions de régulation.

Utilisée à partir de 2009, bien que le terme n’apparaisse qu’en 2015, la blockchain est une technologie de stockage et de transmission d’informations, transparente et sécurisée, fonctionnant sans autorité centrale unique (dans les réseaux publics).

Chaque transaction est enregistrée dans des blocs liés et horodatés, formant une chaîne très difficile à modifier a posteriori sans être détecté, grâce à la cryptographie (voir plus haut). Certaines de ces chaînes sont dites « publiques », puisque librement accessibles en ligne (transactions/échanges de cryptomonnaies), d’autres « privées », lorsque leur accès reste réservé à des utilisateurs identifiés (transactions immobilières).

Utilisée initialement pour les cryptomonnaies comme le Bitcoin, la blockchain sert aussi, par exemple, à lutter contre la contrefaçon, en garantissant l’origine et la qualité des produits. Ses applications s’étendent à la finance, l’immobilier, la logistique, la santé, l’administration ou encore la gestion des contrats intelligents (smart contracts).

La blockchain, souvent présentée comme la panacée en matière de transmission d’informations, offre des avantages théoriques (transparence, désintermédiation, sécurité des données), mais aussi des limites concrètes. Si elle peut sécuriser des votes ou des contrats, son coût énergétique (variable selon le mécanisme de consensus, par exemple Proof of Work vs Proof of Stake), sa complexité et son manque de régulation en font un outil peu accessible et parfois détourné (spéculation, fraudes, surveillance de masse).

Son caractère immuable pose aussi problème : une erreur ou une injustice enregistrée devient difficile à corriger. Enfin, son usage par des acteurs privés ou étatiques interroge sur la réalité de la décentralisation promise.

Le chiffrement de bout en bout signifie que seul·es l’émetteur·rice et le/la destinataire peuvent lire le message : le service intermédiaire ne possède pas la clé. On peut comparer cela à une enveloppe scellée que le facteur ne peut pas ouvrir. Il protège le contenu même si les serveurs sont compromis, et peut inclure des protections comme la « confidentialité persistante » (forward secrecy), la compromission d’une clé ne permettant alors pas de déchiffrer les messages passés.

Le chiffrement de bout en bout constitue une garantie concrète pour converser, s’organiser, consulter sans interception du texte. Par exemple, dans le domaine de la santé, cela permet aux patients d’échanger librement avec leur médecin sans crainte d’interception ; en matière d’information, les journalistes peuvent protéger leurs sources, et dans le domaine de la justice, les avocats peuvent communiquer en toute confidentialité avec leurs clients.

C’est aussi un enjeu politique, souvent contesté au nom de la sécurité publique, notamment à travers le débat sur les « backdoors », des accès cachés permettant aux autorités de contourner le chiffrement et qui suscite des inquiétudes quant à la protection des données personnelles.

Mais le chiffrement laisse souvent visibles des métadonnées (horaires, contacts, adresses IP) et ne protège pas si le téléphone est compromis. D’où l’intérêt de compléments comme les mixnets, qui brouillent les traces des communications, ainsi que d’une certaine hygiène numérique, c’est-à-dire l’adoption de pratiques visant à limiter les risques de compromission.

La cryptographie regroupe les méthodes qui sécurisent l’information : chiffrement (confidentialité), signatures (authenticité), hachage (intégrité), preuves. Elle permet d’échanger ou de stocker des données sans faire confiance à l’intermédiaire et soutient des usages courants comme TLS (protocole qui sécurise les échanges sur le Web), PGP (outil de chiffrement des courriels) ou les certificats (éléments qui authentifient l’identité d’un site ou d’un utilisateur).

C’est une sécurité « par conception », c’est-à-dire basée sur des mécanismes techniques, qui garantissent la protection indépendamment de la confiance accordée à l’intermédiaire, contrairement à la sécurité « par promesse », où l’on s’en remet à un tiers pour protéger les données.

La cryptographie protège vos échanges (messagerie, banque, santé) et rend possibles des droits concrets, comme le secret des correspondances. Mais elle ne règle pas tout : sans protections des métadonnées, on peut encore vous profiler. De même, sans exigences publiques (audits, logiciels libres, absence de portes dérobées), la « sécurité » peut devenir un argument marketing — ou un outil de contrôle.

Dans ce sens, « décentralisé » ne veut pas seulement dire « réparti » : c’est un système distribué où plusieurs autorités contrôlent des composants différents et où aucune autorité n’est pleinement digne de confiance pour toutes les autres. Conséquence clé : un composant interne peut être adversarial (malveillant, compromis, ou simplement non coopératif), donc la sécurité dépend d’un modèle de menace et de seuils (combien d’acteurs peuvent tricher sans casser le système).

L’intérêt de cette décentralisation est de réduire le pouvoir d’un acteur unique (plateforme, opérateur, État, prestataire) sur vos échanges, vos données ou votre accès à un service : moins de « points de coupure », de censure ou de capture. Mais c’est aussi un piège lexical : beaucoup de systèmes sont distribués tout en recentralisant des fonctions (annuaire, modération, séquenceur, hébergeur, etc.). La bonne question devient : qui faut‑il (encore) croire sur parole, sur quoi exactement, et que se passe‑t‑il si quelques opérateurs s’entendent ?

L’interopérabilité désigne la capacité de systèmes, applications ou réseaux hétérogènes à communiquer, échanger et utiliser mutuellement des données ou des services (réseaux sociaux, messageries, cloud, etc.) sans restriction technique ou artificielle (commerciale).

Cette connectivité repose sur des standards ouverts (protocoles, formats, API) qui permettent, par exemple, à différents logiciels ou plateformes de fonctionner ensemble, facilitant ainsi la fluidité et l’efficacité des échanges numériques.

D’un point de vue pratique, si les messageries étaient pleinement interopérables, il nous serait possible d’envoyer un message à un contact depuis Signal vers WhatsApp.

L’interopérabilité constitue un enjeu majeur pour contourner les monopoles technologiques et garantir la pluralité des voix et des acteurs du Web (voir plus bas).

En renforçant la liberté de choix des utilisateur·ices de services ainsi mis en concurrence, l’interopérabilité limite les risques de notre enfermement dans des écosystèmes fermés (« silos technologiques »), qui facilitent notamment les manœuvres de censure ou de restrictions.

En rendant les plateformes compatibles entre elles, cette ouverture des systèmes participe à une compétition équitable au sein du secteur numérique, essentielle pour préserver la diversité des pratiques, des discours et des canaux de diffusion de l’information en ligne.

Le fédivers (fediverse) est un ensemble de services sociaux fédérés : plusieurs serveurs indépendants échangent via des protocoles communs (souvent ActivityPub). On peut suivre et répondre à des comptes hébergés ailleurs, sans plateforme unique ; la modération, les règles et les choix de design varient selon les instances (ex. Mastodon, PeerTube).

Le fédivers offre une sortie partielle du capitalisme de plateforme : moins de dépendance à un acteur, plus de pluralité de gouvernances (associations, médias, collectivités) et moins d’algorithmes publicitaires imposés (souvent des fils plus chronologiques). En contrepartie, l’expérience peut être moins fluide (en matière d’ergonomie ou d’algorithmes de découverte) et la modération plus complexe. On y gagne aussi en portabilité et en choix de règles locales.

Un graphe de connaissances représente des entités (personnes, lieux, œuvres, produits) et leurs relations dans une base structurée. Il alimente recherche, recommandation, assistants et IA : on ne manipule plus des pages, mais des objets reliés par des faits (ou des énoncés de faits), des catégories (prises dans ce que l’on appelle des vocabulaires et parfois des ontologies) et des identifiants. Il peut être construit à partir de données publiques ou de données privées.

Ces graphes influencent ce que vous voyez, achetez, apprenez : ils organisent la visibilité et les « vérités » opérationnelles (ce qui est mis en avant, ce qui est invisible). Quand ils sont propriétaires, ils deviennent un avantage stratégique opaque : biais, erreurs, exclusions et pouvoir de marché s’y logent loin du débat public, tout en nourrissant des IA. D’où l’idée d’une option publique.

Internet est l’infrastructure de réseaux interconnectés qui transporte des paquets de données grâce à des protocoles (TCP/IP). Il assure le routage (BGP), l’adressage et, via des briques comme le DNS, à savoir la traduction (appelée « résolution ») des noms (de site Web) en adresses (IP). Il ne définit pas les contenus : il permet la circulation de données et fournit la capacité d’interconnecter des réseaux hétérogènes (universités, opérateurs, États, entreprises), avec une architecture pensée pour continuer à fonctionner malgré des pannes éventuelles.

Accès à l’information, travail, banque, soins, démarches : tout repose sur cette infrastructure. Ses points de contrôle (FAI, câbles, DNS, centres de données) peuvent devenir des points de censure, de coupure, de priorisation (neutralité du Net) ou de surveillance. Comprendre Internet, c’est repérer où se logent pouvoir, dépendances et risques de « mise à l’arrêt ».

Les métadonnées sont les données « sur » d’autres données ou actions réalisées par le truchement de dispositifs numériques et qui laissent des traces : qui contacte qui, quand, d’où, combien de temps, quelle taille de message, quel appareil, etc. Elles sont produites par le fonctionnement même des réseaux et des services, indépendamment du contenu, et demeurent faciles à stocker, corréler et traiter à grande échelle (graphes, IA).

Même si vos messages sont chiffrés, les métadonnées suffisent souvent à reconstituer un réseau social, des routines, des lieux ou des vulnérabilités potentielles (santé, travail, engagements). Elles alimentent publicité ciblée, scoring, retenue légale des données ou renseignement. Protéger les métadonnées, c’est protéger des libertés quand l’observation du « qui/quand/où » devient plus stratégique que le message lui-même — parfois même sans en lire un seul mot.

Un mixnet est un réseau d’anonymisation qui mélange des messages de nombreux utilisateurs avant de les relayer, afin de casser la corrélation entre entrée et sortie. Il introduit du délai, du brassage et parfois du trafic de couverture, sur plusieurs relais, pour rendre la corrélation statistique beaucoup plus difficile qu’avec le seul chiffrement au prix d’un peu plus de latence.

Pour un·e journaliste, un·e militant·e, syndicaliste ou personne vulnérable, cela réduit le risque d’être cartographié·e via ses contacts et ses habitudes. Contrairement à un VPN (qui déplace la confiance) ou à des solutions centrées sur le contenu, un mixnet cible la fuite de métadonnées. C’est une protection contre la surveillance de masse quand l’enjeu n’est plus seulement le message, mais les liens sociaux qui le rendent traçable.

En matière d’intelligence artificielle, un modèle de langage apprend, à partir de corpus, à prédire la suite d’une séquence (mots/sous‑mots, « tokens »). Les modèles récents peuvent être adaptés à de multiples tâches (résumer, traduire, répondre, coder) puis réentraînés sur des exemples de consignes et de réponses attendues (des paires « demande → bonne réponse ») pour qu’ils apprennent à répondre à une instruction — et pas seulement à poursuivre un texte. Ils produisent du texte plausible, mais ne sont pas des moteurs de vérité : ils peuvent se tromper et/ou « halluciner ».

Ils deviennent des interfaces généralistes (assistance, recherche, bureautique), donc influencent l’accès au savoir et la production de textes. Enjeux concrets : fiabilité, biais, traçabilité des sources, confidentialité (ce que l’on saisit), dépendances à des modèles fermés et impacts sociaux (travail, éducation, information).

Un LLM est un modèle de langage de très grande taille, souvent basé sur l’architecture Transformer, préentraînée à prédire le prochain token puis affiné avec des exemples d’instructions et des retours (parfois humains) pour produire des réponses plus utiles et conformes à certaines règles. Il « généralise » à de nombreux usages, autrement dit, il réutilise des régularités apprises sur de grands corpus pour répondre à des demandes nouvelles. Il peut également produire des réponses convaincantes, mais fausses.

Les LLM deviennent une interface pour agir : ce qu’ils résument, reformulent ou recommandent peut orienter décisions (actions) et perceptions. D’où une nécessaire vigilance pratique : vérifier, citer, comprendre les limites, distinguer assistance rédactionnelle, recherche documentaire et expertise.

La modération de contenus repose sur une combinaison d’outils automatisés (IA, mots-clés, reconnaissance d’images) et d’équipes humaines pour analyser, classer et agir sur les publications.

Les algorithmes détectent les contenus manifestement illicites (terrorisme, pédopornographie) via des bases de signatures/hachages et des listes partagées, tandis que des modérateurs humains traitent les cas complexes (ironie, contexte culturel).

Par exemple, Facebook utilise des systèmes internes pour analyser textes et images à grande échelle. Comme d’autres plateformes, YouTube emploie des milliers de modérateurs pour évaluer les signalements, avec d’ailleurs des conséquences directes sur leur santé mentale.

Malgré les moyens mis en œuvre, ces outils peinent à distinguer la satire de la haine ou à s’adapter aux nuances linguistiques, entraînant des erreurs (faux positifs/négatifs). En 2023, Twitter (devenu X) a vu son taux de modération chuter après des licenciements massifs, illustrant la dépendance aux ressources humaines malgré l’IA.

La modération se situe au cœur des tensions entre sécurité et libertés fondamentales. Les plateformes, devenues des espaces publics privés, fixent des règles souvent opaques (voir « algorithme), suscitant des accusations de censure ou de complaisance.

En 2021, la suspension de Donald Trump par Twitter après l’assaut du Capitole a relancé le débat sur le pouvoir des GAFAM à influencer la vie politique.

De même, le désengagement de X en matière de modération ne se limite pas à une recherche de rentabilité accrue, mais s’est accompagné d’un changement de politique et de priorités de modération, avec des effets contestés/observés sur la visibilité de certains contenus, ce qui relance le débat sur la responsabilité des plateformes.

En Europe, le Digital Services Act (DSA, 2024) impose désormais plus de transparence, mais sa mise en œuvre reste inégale.

Par ailleurs, certains États instrumentalisent systématiquement la modération pour museler l’opposition, tandis que des mouvements comme #StopHateForProfit poussent les plateformes à agir contre la désinformation. La question centrale reste : qui doit décider des limites de la liberté d’expression, et selon quels critères démocratiques.

La neutralité du Net est le principe selon lequel un fournisseur d’accès ne doit pas bloquer, ralentir, prioriser, ni tarifer différemment des flux selon les services (streaming, messagerie, etc.). Une gestion différenciée du trafic n’est admise que dans des cas encadrés (sécurité, congestion, obligations légales), sans créer un Internet « à plusieurs vitesses » avec des accès dits « prémiums ».

La garantie de la neutralité du net constitue un garde‑fou pour l’égalité d’accès (information, services), le pluralisme et l’innovation : un petit site ne doit pas être pénalisé face à un grand acteur capable de se payer une « voie rapide ». Sans neutralité, l’opérateur peut devenir un « éditeur » de fait de ce qui circule — plus ou moins bien selon les moyens déboursés par ses clients.

L’Open Graph Protocol est un format de métadonnées que des sites placent dans leurs pages (balises og : title, og:image, etc.) pour décrire titres, images et objets « partageables ». Popularisé par Facebook, il a standardisé les aperçus de liens et a permis d’agréger des signaux sociaux à grande échelle, en articulant Web « ouvert » et plateforme.

Pour l’utilisateur, cela signifie que lorsqu’il partage un lien sur les réseaux sociaux, le titre, l’image et la description apparaissent automatiquement et de façon cohérente, améliorant ainsi la visibilité du contenu. Par exemple, lorsqu’un article de presse intègre les balises og : title et og : image, son aperçu sur Facebook affiche automatiquement le titre de l’article et une image associée, facilitant l’engagement des lecteurs.

OGP a l’air anodin (ce sont les « cartes » avec titre, image et résumé quand on partage un lien), mais il pèse sur la circulation de l’information : il fixe d’emblée le cadrage d’un contenu (ce que les autres voient avant de cliquer) et influence donc l’attention, la viralité, voire les malentendus.

Pour les médias, associations ou collectivités, c’est un outil concret de maîtrise de la présentation (éviter des aperçus erronés, trompeurs ou dégradants). Côté plateformes, il facilite l’aspiration automatique de métadonnées par leurs robots (prévisualisation, classement, recommandation) : ce n’est pas « le traçage » en soi, mais c’est une brique de l’économie de visibilité, où une partie de la valeur et du contexte du Web se rejoue dans les interfaces des grandes plateformes.

Un VPN (Virtual Private Network) crée un tunnel chiffré entre votre appareil et un serveur (entreprise ou prestataire), afin de sécuriser une connexion et/ou d’accéder à un réseau à distance. Il protège le transport sur une portion du trajet, mais ne « supprime » pas les métadonnées : il déplace la confiance (du Wi‑Fi/FAI vers l’opérateur du VPN).

Utile pour le télétravail ou certains usages sur réseaux publics, un VPN ne garantit pas l’anonymat : le fournisseur du VPN peut potentiellement voir/journaliser une partie des informations, et certains services promettent plus qu’ils n’offrent. La question pratique : à qui confier ce rôle d’intermédiaire, avec quelles garanties (politique de logs, audits, transparence, etc.) ?

Le W3C (World Wide Web Consortium), fondé par Tim Berners-Lee, le principal inventeur du Web, est l’organisme qui définit et publie les standards (HTML, CSS, HTTP, etc.) qui décrivent et encadrent le fonctionnement des couches techniques du Web.

Un standard ouvert est public, implémentable par tous et (en principe) sans droits d’auteur ; il garantit l’interopérabilité et limite la prolifération de formats propriétaires. Ce « code commun » du Web se construit en théorie par consensus et tests d’implémentation.

L’existence du W3C et des standards ouverts évitent que votre navigation dépende d’une seule entreprise : vous pouvez ainsi changer de navigateur ou d’hébergeur sans perte excessive. Pour les services publics, c’est un levier de souveraineté numérique (moins de verrouillage, plus de transparence, meilleure pérennité des données), donc un enjeu démocratique très concret : on perd moins facilement la maîtrise de ce qui est standardisé que d’une boîte noire.

Le Web est une application d’Internet fondée initialement sur des pointeurs (URL, appelées URI dans les standards), un protocole de transfert (HTTP) et un langage (HTML) : on publie des contenus en nommant (via des URI) des ressources, en donnant à accès à des contenus (protocole HTTP) et en les reliant via des liens « hypertextes » (liens dits HTML).

En même temps, le Web est aussi un « réseau de réseaux » grâce à sa couche de nommage universelle qui permet d’entrecroiser des protocoles différents (FTP, autrefois Gopher, etc.).

Le Web sémantique ajoute des données structurées (métadonnées, vocabulaires, RDF/graphes) pour que des machines puissent relier des « choses » (personnes, lieux, événements) et non seulement des pages, et interroger ces liens (SPARQL, schémas partagés, schema.org).

Le Web sémantique peut améliorer la recherche, les données publiques, les services urbains, la culture (catalogues) ou la santé. Mais la même « mise en forme du sens » peut aussi nourrir des silos privés : ce qui rend le monde lisible sert aussi au profilage publicitaire, à la recommandation opaque et à des IA adossées à des bases fermées. D’où l’enjeu que la sémantique soit réellement au service du public.

Article

Le progrès technologique nous éblouit. Se pourrait-il qu’il nous aveugle en plein jour ?

Dossier

L'impact de l’IA dépasse largement le périmètre de l’innovation technologique et prend désormais part à des choix politiques, sans que les citoyens aient leur mot à dire...

Article

Comme dans les pires dystopies, ce « golem » moderne, et bien réel, pourrait-il devenir assez autonome pour s’émanciper de ses maîtres ?

Article

Comment déterminer la balance bénéfices-risques de technologies aux progrès à la fois fulgurants et exponentiels ?

Article

Longtemps confinée aux pages de la science-fiction dans l’esprit du plus grand nombre, cette classe de technologies est désormais omniprésente dans notre quotidien numérique.

Article

La Revue dessinée a publié plusieurs reportages sur les conséquences écologiques et sociales de nos usages digitaux. Avec humour, l'un de ces textes nous permet de prendre la mesure du piège écologique que constitue notre addiction au numérique.

Article

La sobriété énergétique s’imposera à n’en pas douter à nos futurs usages numérique. Quelques exemples des pistes déjà suivies par le monde de la tech.

Article

Pourquoi les outils numériques se sont popularisés pour participer en ligne au débat démocratique ? Quels en sont les effets et les limites actuelles ? Revue de littérature scientifique.

Article

Quelles perspectives les débats actuels sur la souveraineté numérique ouvrent-ils pour l’évolution des services publics locaux ?